Чат-боты с искусственным интеллектом могут диагностировать заболевания дома. Насколько они хороши?

Чат-боты с искусственным интеллектом могут диагностировать заболевания дома. Насколько они хороши?

Бенджамин Толчин, невролог и специалист по этике из Йельского университета, привык видеть пациентов, которые искали свои симптомы в Интернете, прежде чем прийти к нему на прием — врачи уже давно пытаются препятствовать этой практике. «Доктор. «Google», как известно, лишен контекста и склонен использовать ненадежные источники.

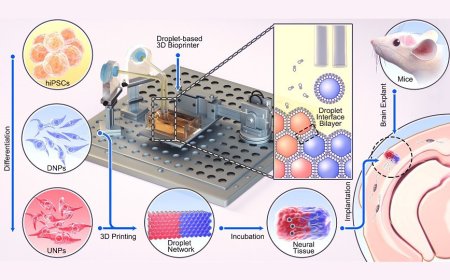

Но в последние месяцы Толчин начал наблюдать пациентов, которые используют новый, гораздо более мощный инструмент для самодиагностики: чат-боты с искусственным интеллектом, такие как ChatGPT от OpenAI, последнюю версию поисковой системы Microsoft Bing (основанной на программном обеспечении OpenAI) и Google. Мед-ПаЛМ. Эти большие языковые модели (LLM), обученные на тексте в Интернете, предсказывают следующее слово в последовательности, чтобы отвечать на вопросы в человеческом стиле. Столкнувшись с острой нехваткой медицинских работников, исследователи и медицинские работники надеются, что боты смогут помочь ответить на вопросы людей. Первоначальные тесты исследователей показывают, что эти программы искусственного интеллекта гораздо более точны, чем поиск Google. Некоторые исследователи прогнозируют, что в течение года крупный медицинский центр объявит о сотрудничестве с использованием чат-ботов LLM для взаимодействия с пациентами и диагностики заболеваний.

ChatGPT был выпущен только в ноябре прошлого года, но Толчин говорит, что по крайней мере два пациента уже сказали ему, что использовали его для самостоятельной диагностики симптомов или поиска побочных эффектов лекарств. По его словам, ответы были разумными. «Это очень впечатляет и очень обнадеживает с точки зрения будущего потенциала», — добавляет он.

Тем не менее, Толчин и другие обеспокоены тем, что у чат-ботов есть ряд подводных камней, включая неуверенность в точности информации, которую они предоставляют людям, угрозы конфиденциальности, а также расовую и гендерную предвзятость, укоренившуюся в тексте, на основе которого извлекаются алгоритмы. Он также задается вопросом, как люди будут интерпретировать информацию. По словам Толчина, существует новый потенциальный вред, которого не было при простом поиске в Google или проверке симптомов.

Диагностика с помощью искусственного интеллекта

В последние годы медицинская практика все больше переходит в онлайн. Во время пандемии COVID количество сообщений от пациентов врачам через цифровые порталы увеличилось более чем на 50 процентов. Многие медицинские системы уже используют более простые чат-боты для выполнения таких задач, как планирование посещений и предоставление людям общей информации о состоянии здоровья. «Это сложная область, потому что она так быстро развивается», — говорит Нина Сингх, студентка-медик Нью-Йоркского университета, изучающая искусственный интеллект в медицине.

Но хорошо начитанные чат-боты LLM могут вывести сотрудничество врача и ИИ — и даже диагностику — на новый уровень. В исследовании, опубликованном на сервере препринтов medRxiv в феврале и еще не прошедшем рецензирование, эпидемиолог Эндрю Бим из Гарвардского университета и его коллеги написали 48 подсказок, сформулированных как описания симптомов пациентов. Когда они передали их в GPT-3 Open AI — версию алгоритма, который в то время использовался в ChatGPT, — три основных потенциальных диагноза LLM для каждого случая включали правильный в 88 процентах случаев. Для сравнения, врачи могли сделать это в 96 процентах случаев, если им давались одни и те же подсказки, тогда как люди без медицинского образования могли сделать это в 54 процентах случаев.

«Для меня безумно удивительно, что эти функции автозаполнения могут так хорошо выполнять проверку симптомов прямо из коробки», — говорит Бим. Предыдущие исследования показали, что онлайн-программы проверки симптомов — компьютерные алгоритмы, помогающие пациентам в самостоятельной диагностике — дают правильный диагноз только среди трех наиболее вероятных вариантов в 51 проценте случаев.

Чат-боты также проще в использовании, чем онлайн-проверщики симптомов, поскольку люди могут просто описать свой опыт, а не впихивать его в программы, вычисляющие статистическую вероятность заболевания. «Люди сосредотачиваются на искусственном интеллекте, но прорывом является интерфейс — это английский язык», — говорит Бим. Кроме того, боты могут задавать пациенту дополнительные вопросы, как это сделал бы врач. Тем не менее, он признает, что описания симптомов в исследовании были тщательно написаны и содержали один правильный диагноз — точность могла быть ниже, если описания пациента были плохо сформулированы или не содержали критической информации.

Устранение ловушек ИИ

Бим обеспокоен тем, что чат-боты LLM могут быть подвержены дезинформации. Их алгоритмы предсказывают следующее слово в серии на основе его вероятности в онлайн-тексте, на котором оно было обучено, что потенциально придает равный вес, скажем, информации из Центров США по контролю и профилактике заболеваний и случайной ветке на Facebook. Представитель OpenAI рассказала Scientific American , что компания «предварительно тренирует» свою модель, чтобы гарантировать, что она отвечает так, как хочет пользователь, но она не уточнила, придает ли она больший вес определенным источникам*. Она добавляет, что профессионалы в различных областях с высоким уровнем риска помог GPT-4 избежать «галлюцинаций» — ответов, при которых модель угадывает ответ, создавая новую несуществующую информацию. Из-за этого риска компания включает заявление об отказе от ответственности, в котором говорится, что ChatGPT не следует использовать для диагностики серьезных заболеваний, предоставления инструкций о том, как вылечить заболевание или решать опасные для жизни проблемы.

Хотя ChatGPT обучается только на информации, доступной до сентября 2021 года, кто-то, стремящийся, например, распространить ложную информацию о вакцинах, может наводнить Интернет контентом, предназначенным для того, чтобы в будущем его могли получить студенты LLM. Чат-боты Google продолжают учиться на новом контенте в Интернете. «Мы ожидаем, что это станет еще одним фронтом попыток направить разговор в нужное русло», — говорит Одед Нов, компьютерный инженер Нью-Йоркского университета.

Одним из решений может стать принуждение чат-ботов ссылаться на свои источники, как это делает движок Microsoft Bing. Тем не менее, многие исследования и опыт пользователей показали, что LLM могут галлюцинировать несуществующие источники и форматировать их так, чтобы они выглядели как надежные цитаты. Определение того, являются ли эти цитируемые источники законными, возложит большое бремя на пользователя. Другие решения могут включать в себя разработчиков LLM, контролирующих источники, из которых черпают боты, или армии проверщиков фактов, вручную устраняющие ложь по мере того, как они ее видят, что удержит ботов от предоставления таких ответов в будущем. Однако это будет трудно масштабировать с учетом количества контента, создаваемого ИИ.

Google использует другой подход со своим чат-ботом LLM Med-PaLM, который извлекает из огромного набора данных реальные вопросы и ответы от пациентов и поставщиков услуг, а также экзаменов по медицинским лицензиям, хранящихся в различных базах данных. Когда исследователи из Google протестировали эффективность Med-PaLM по разным «осям», включая соответствие медицинскому консенсусу, полноту и возможность вреда, в исследовании препринта, его ответы совпадали с медицинским и научным консенсусом в 92,6 процентах случаев. В целом врачи-люди набрали 92,9 процента. В ответах чат-ботов чаще отсутствовало содержание, чем в ответах людей, но вероятность того, что ответы нанесут вред физическому или психическому здоровью пользователей, была немного ниже.

Способность чат-ботов отвечать на медицинские вопросы не удивила исследователей. Более ранние версии MedPaLM и ChatGPT прошли экзамен на получение медицинской лицензии в США . Но Алан Картикесалингам, ученый-клиницист из Google и автор исследования MedPaLM, говорит, что знание того, как на самом деле выглядят вопросы и ответы пациента и поставщика услуг, позволяет ИИ взглянуть на более широкую картину здоровья человека. «Реальность — это не экзамен с несколькими вариантами ответов», — говорит он. «Это тонкий баланс пациента, поставщика услуг и социального контекста».

Скорость, с которой чат-боты LLM могут проникнуть в медицину, беспокоит некоторых исследователей — даже тех, кто в остальном воодушевлен потенциалом новой технологии. «Они внедряют [технологию] до того, как регулирующие органы успевают ее догнать», — говорит Марзие Гассеми, ученый-компьютерщик из Массачусетского технологического института.

Увековечивание предвзятости и расизма

Гассеми особенно обеспокоен тем, что чат-боты будут увековечивать расизм, сексизм и другие виды предрассудков, которые сохраняются в медицине и в Интернете. «Они обучены на данных, полученных людьми, поэтому у них есть все предубеждения, которые только можно себе представить», — говорит она. Например, женщинам реже, чем мужчинам, назначают обезболивающие, а у чернокожих людей чаще, чем у белых, диагностируют шизофрению и реже диагностируют депрессию — реликты предубеждений в медицинском образовании и социальных стереотипов, которые ИИ можно получить от своего обучения. В неопубликованном исследовании Бим обнаружил, что, когда он спрашивает ChatGPT, доверяет ли он описанию человеком своих симптомов, он с меньшей вероятностью будет доверять определенным расовым и гендерным группам. OpenAI на момент публикации не ответила о том, как и борется ли она с такого рода предвзятостью в медицине.

Искоренить расизм в Интернете невозможно, но Гассеми говорит, что разработчики смогут проводить упреждающие проверки, чтобы увидеть, где чат-бот дает предвзятые ответы, и приказать ему остановиться, или выявить распространенные предубеждения, которые всплывают в его разговорах с пользователями.

Вместо этого ответ может лежать в человеческой психологии. Когда команда Гассеми создала «злого» чат-бота LLM, который давал предвзятые ответы на вопросы об неотложной медицинской помощи, они обнаружили, что и врачи, и неспециалисты с большей вероятностью последуют его дискриминационным советам, если он сформулирует свои ответы как инструкции. Когда ИИ просто сообщал информацию, пользователи вряд ли проявят подобную дискриминацию.

Картикесалингам говорит, что разработчики, обучающие и оценивающие MedPaLM в Google, разнообразны, что может помочь компании выявить и устранить предвзятости в чат-боте. Но он добавляет, что устранение предубеждений — это непрерывный процесс, который будет зависеть от того, как используется система.

Обеспечение справедливого отношения к пациентам со стороны LLM имеет важное значение для того, чтобы люди доверяли чат-боту, что само по себе является непростой задачей. Неизвестно, например, делает ли поиск ответов в Google более проницательным, чем получение ответа от чат-бота.

Толчин обеспокоен тем, что дружелюбное поведение чат-бота может заставить людей слишком сильно ему доверять и предоставлять личную информацию, которая может подвергнуть их риску. «Существует определенный уровень доверия и эмоциональной связи», — говорит он. Согласно заявлениям об отказе от ответственности на веб-сайте OpenAI, ChatGPT собирает информацию от пользователей, такую как их местоположение и IP-адрес. По словам Толчина, добавление, казалось бы, безобидных заявлений о членах семьи или хобби может потенциально поставить под угрозу неприкосновенность частной жизни.

Также неясно, будут ли люди терпеть получение медицинской информации от чат-бота вместо врача. В январе приложение для психического здоровья Koko, которое позволяет волонтерам предоставлять бесплатные и конфиденциальные советы, экспериментировало с использованием GPT-3 для написания ободряющих сообщений примерно 4000 пользователям. По словам соучредителя Koko Роба Морриса, бот помогал волонтерам писать сообщения гораздо быстрее, чем если бы им приходилось составлять их самостоятельно. Но сообщения становились менее эффективными, когда люди знали, что разговаривают с ботом, и компания быстро свернула эксперимент. «Имитация сочувствия кажется странной и пустой», — написал Моррис в Твиттере. Эксперимент также вызвал негативную реакцию и опасения, что эксперименты проводились на людях без их согласия.

Недавний опрос, проведенный Исследовательским центром Pew, показал, что около 60 процентов американцев «почувствовали бы себя некомфортно, если бы их собственный поставщик медицинских услуг полагался на искусственный интеллект для таких вещей, как диагностика заболеваний и рекомендации лечения». Тем не менее, люди не всегда хорошо понимают разницу между ботом и человеком — и эта двусмысленность, вероятно, будет только возрастать по мере развития технологий. В недавнем препринтном исследовании Нов, Сингх и их коллеги разработали медицинский тест Тьюринга, чтобы проверить, смогут ли 430 добровольцев отличить ChatGPT от врача. Исследователи не просили ChatGPT проявлять особую чуткость или говорить как врач. Они просто попросили его ответить определенным количеством слов на набор из 10 заранее заданных вопросов пациентов. Добровольцы правильно идентифицировали и врача, и бота в среднем только в 65 процентах случаев.

Девин Манн, врач и исследователь информатики из NYU Langone Health и один из авторов исследования, подозревает, что добровольцы улавливали не только особенности человеческих высказываний, но и детали ответов. Системы искусственного интеллекта, обладающие бесконечным временем и терпением, могут объяснять вещи медленнее и полнее, в то время как занятой врач может дать более краткий ответ. Дополнительная информация и сведения могут оказаться идеальными для некоторых пациентов, говорит он.

Исследователи также обнаружили, что пользователи доверяют чат-боту, отвечая на простые вопросы. Но чем сложнее становился вопрос – и чем выше был связанный с ним риск или сложность – тем меньше они хотели доверять диагнозу чат-бота.

Манн говорит, что, вероятно, неизбежно, что системы искусственного интеллекта в конечном итоге будут выполнять некоторую часть диагностики и лечения. Главное, по его словам, это то, что люди знают, что врач доступен, если они недовольны чат-ботом. «Они хотят иметь этот номер, чтобы позвонить, чтобы получить новый уровень обслуживания», — говорит он.

Манн предсказывает, что крупный медицинский центр вскоре анонсирует чат-бота с искусственным интеллектом, который поможет диагностировать заболевания. Такое партнерство поднимет множество новых вопросов: будут ли пациенты и страховщики взимать плату за эту услугу, как обеспечить защиту данных пациентов и кто будет нести ответственность, если кому-то причинят вред советы чат-бота. «Мы также думаем о следующих шагах и о том, как научить поставщиков медицинских услуг выполнять свою роль» в трехстороннем взаимодействии между ИИ, врачом и пациентом, — говорит Ноя.

Тем временем исследователи надеются, что внедрение будет продвигаться медленно — возможно, на данный момент оно будет ограничено клиническими исследованиями, пока разработчики и медицинские эксперты устранят недостатки. Но Толчин находит одну вещь обнадеживающей: «Когда я проверил это, я был воодушевлен, увидев, что оно довольно последовательно рекомендует оценку врачом», - говорит он.

Эта статья является частью продолжающейся серии статей о генеративном искусственном интеллекте в медицине.

* Примечание редактора (03.04.23): Это предложение было обновлено, чтобы прояснить, как OpenAI предварительно обучает свою модель чат-бота для предоставления более надежных ответов.

Какова ваша реакция?