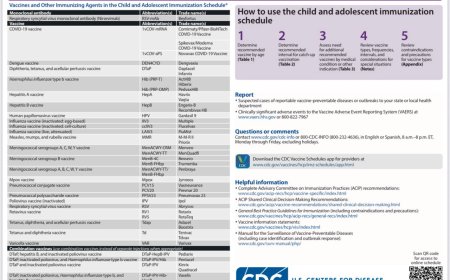

Обзор литературы по теме AI in Healthcare (2024–2025), ГНМБ

Обзор литературы по теме AI in Healthcare (2024–2025), ГНМБ

- клинические приложения ИИ (диагностика, прогнозирование)

- языковые модели (LLM) в медицине

- этика и регулирование

- генеративный ИИ (изображения, текст)

- медицинская визуализация

1. Клинические приложения ИИ (диагностика, прогноз, обработка данных пациента)

- Han et al. (Lancet Digital Health, 2024) – Систематический обзор 86 РКИ применения ИИ в клинической практике показал растущий интерес к системам глубокого обучения (в основном для обработки изображений в гастроэнтерологии и радиологии). В 81% испытаний отмечены положительные первичные результаты (улучшенная диагностическая точность), однако авторы подчёркивают односторонний характер исследований (в большинстве – одноцентровые), отсутствие разнородности выборок и ограниченность исходов, что ставит под сомнение обобщаемость этих данных[1].

- Wilhelm et al. (Lancet Regional Health Europe, 2024) – Систематический обзор РКИ показал, что в 12 из 19 испытаний ИИ-технологий сообщалось о улучшении клинических исходов: например, сокращение продолжительности госпитализации и снижение летальности (в одном исследовании летальность упала с 21.3% до 9.0%). При этом ни одно испытание не выявило возрастания побочных эффектов, но авторы констатируют, что негативные исходы пациентов часто не анализируются в принципе[2].

- Heetderks et al. (Nature Communications, 2025) – В исследовании на основе данных крупного клинического испытания болезни Альцгеймера показано, что ИИ-адаптация дизайна позволила выявить субгруппу «медленно прогрессирующих» пациентов, для которых новый препарат (lanabecestat) дал 46% замедление когнитивного спада по сравнению с плацебо[3]. Это демонстрирует потенциал ИИ в селекции пациентов и «спасении» ранее неудавшегося лечения за счёт персонализации.

- Lu et al. (Scientific Reports, 2025) – Разработана модель машинного обучения на основе электронных медкарт для прогнозирования риска рака поджелудочной железы в ближайшие 2–3 года. Модель выявила 73 фактора риска и показала AUROC 0.742, причём у 1% пациентов с высшим рисковым баллом вероятность заболевания была в 6 раз выше, чем в общей популяции[4].

- Из российских источников: Обзор «Перспективы применения ИИ для цифровой трансформации здравоохранения» (Российский журнал телемедицины, 2024) подчёркивает большой потенциал ИИ в диагностике, лечении и прогнозировании: алгоритмы анализа больших данных пациентов помогают врачам ставить более точные диагнозы и назначать эффективное лечение[5]. Вместе с тем отмечается, что в России внедрение ИИ в медицине пока на ранней стадии: системы преимущественно разрабатываются в радиологии, а их потенциал «ещё не реализован в полной мере»[6]. Кроме того, обзор в журнале Biomedical Sciences (2024) напоминает, что ИИ успешно анализирует рентген-, КТ- и МРТ-изображения для выявления онкологических и других заболеваний[7].

2. Языковые модели в медицине (LLMs, медицинские ассистенты)

- Kwon et al. «Towards conversational diagnostic AI» (Nature, 2025) – Представлен AMIE – LLM, оптимизированная для диагностического диалога. В рандомизированном «слепом» исследовании 159 клинических случаев двадцать терапевтов сравнивали свои диагнозы с AMIE. По оценке независимых экспертов, AMIE показала значительно лучшую точность диагностики и превзошла врачей по 30 из 32 измеренных показателей (оценка специалистов) и 25 из 26 (по мнению «пациентских актёров»)[8].

- Liu et al. «A generalist medical language model for disease diagnosis assistance» (Nature Medicine, 2025) – Предложена «универсальная» LLM (MedFound, 176 млрд параметров), обученная на клинических данных и оптимизированная для цепочки рассуждений. Авторы сообщают, что MedFound существенно превзошла другие модели (в том числе специализированные) во множестве сценариев (8 различных специальностей, частые и редкие заболевания)[9]. Модель продемонстрировала способность помогать врачам в составлении дифференциального диагноза и интегрирована в клинические оценки.

- Ning et al. «The diagnostic and triage accuracy of GPT-3 AI» (Lancet Digit Health, 2024) – В наблюдательном исследовании оценивалось качество диагностических рекомендаций GPT-3. Он правильно включал окончательный диагноз в свой топ-3 вариантов в 88% случаев, что уступает 96% у врачей, но заметно лучше, чем 54% у непрофессионалов. В то же время модель хуже справилась с определением необходимости неотложной помощи (GPT-3 – 71% правильной «тяжести состояния» vs 91% у врачей)[10].

- Haltaufderheide & Ranisch «The ethics of ChatGPT in medicine and healthcare» (npj Digital Medicine, 2024) – Систематический обзор этики LLM в медицине. Авторы выделяют четыре класса приложений и отмечают ключевые плюсы (анализ данных, информирование, поддержка решений) и минусы: справедливость, предвзятость, непричинение вреда, прозрачность и конфиденциальность. Особую опасность представляет генерация убедительного, но ложного контента. Постоянно звучит призыв к этическим руководствам и участию человека в контроле работы ИИ[11].

- Из российских источников: Прямых публикаций о LLM в медицине немного, но в обзорах подчёркивается роль ИИ как вспомогательного инструмента, а также необходимость этических ограничений (см. раздел 5 ниже).

3. Медицинская визуализация (анализ МРТ, КТ, рентгена и т.д.)

- Chen et al. «AI assistance reduces radiologist workload» (npj Digital Medicine, 2024) – Мета-анализ 36 исследований показал, что при совместной работе с ИИ время чтения рентгеновских снимков в среднем сокращается на 27%. Если ИИ выступает вторым читателем, объём анализируемых изображений снижается на 44.5%, а при предварительном отборе – на 61.7%. При этом суммарная чувствительность сохраняется или увеличивается (отн. чувствительность 1.12)[12].

- Wenderott et al. «Efficiency effects of AI in imaging workflows» (npj Digital Medicine, 2024) – Систематический обзор 48 исследований, из которых 67% показали сокращение времени рутинных задач благодаря ИИ. Однако на основе 12 подходящих для мета-анализа объединённых данных статистически значимого эффекта выявлено не было. Выделены пять сценариев работы, наиболее распространённый из которых – ИИ в роли второго читателя или ассистента[13].

- Wilkinson et al. «AI in imaging of soft-tissue and bone tumours» (Lancet eBioMedicine, 2025) – В скопус-обзоре 325 публикаций по ИИ в визуализации опухолей скелета/соединительной ткани констатируется, что большинство систем остаются на уровне концептов. Средний балл соответствия рекомендациям (CLAIM и FUTURE-AI) составил лишь ~28/53 и 5/30 соответственно, что говорит о низком качестве докладов. Авторы настаивают на фокусе на клинических задачах, алгоритмической объяснимости и строгой валидации[14].

- Pai et al. «Foundation model for cancer imaging biomarkers» (Nat Mach Intell, 2024) – Предложена глубоко-обученная универсальная модель (self-supervised) на 11467 снимках опухолей разных органов и модальностей. Показано, что такая модель быстрее изучает «биомаркеры» изображения и превосходит стандартные подходы на ограниченных данных. Модель устойчива к изменениям входных данных и коррелирует с биологией опухолей, что может ускорить поиск новых диагностических маркеров[15].

- Из российских источников: В обзоре Biomedical Sciences (2024) отмечается, что глубокие нейросети успешно обрабатывают рентген, КТ, МРТ и находят онкологические, сердечно-сосудистые и другие патологии[7]. Аналогично в «Российском журнале телемедицины» указано, что ИИ-системы могут анализировать медизображения и вычленять патологии для постановки точного диагноза[16], что помогает врачам принимать обоснованные решения.

4. Генеративный ИИ (медицинские изображения, синтетические данные, text2image)

- Wang et al. «Self-improving generative foundation model (MINIM) for synthetic medical image generation» (Nature Medicine, 2024) – Создана мультимодальная модель MINIM, способная синтезировать медицинские изображения по текстовым запросам для разных органов и модальностей. Врачебная оценка и метрики подтвердили высокое качество генерации. С помощью MINIM синтетические данные улучшили решения ИИ: прирост точности составил в среднем +12% для офтальмологии, +15% – легких, +13% – мозга, +17% – молочной железы. Модель также продемонстрировала клиническую пользу: сгенерированные ею функции помогли лучше предсказывать HER2-позитивность рака молочной железы и идентифицировать EGFR-мутантные опухоли лёгких[17].

- Loni et al. «Review on generative AI models for synthetic medical text, time series, and longitudinal data» (npj Digital Medicine, 2025) – Скопус-обзор 52 работ по генерации синтетических данных ЭМК (текст, временные ряды, лонгитюдные данные). Выявлено, что сохранение приватности – ключевая цель при создании таких данных; наиболее эффективны GAN-сети для временных рядов, вероятностные модели для лонгитюдиналей и большие языковые модели – для медицинских текстов. Отмечается нехватка надёжных метрик для оценки риска ре-идентификации пациентов[18].

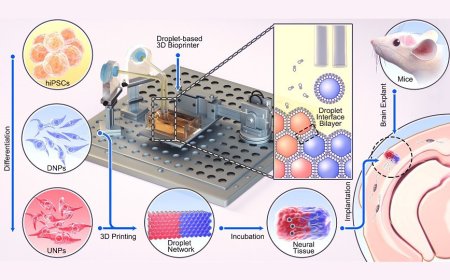

- Lee et al. «Multimodal generative AI for 3D medical images and videos» (npj Digital Medicine, 2025) – Перспектива по адаптации современных видео-текстовых моделей (видео-Фреймы как «томограмма») для клинических задач. Авторы предлагают использовать мультимодальные «видео-LAM» для анализа 3D-данных (КТ/МРТ) и эндоскопий в реальном времени. Описаны уникальные свойства медизображений (связь смежных срезов, метаданные) и приложения (автоматизированные отчёты, поиск похожих случаев, обучение). Сигнализируется о проблемах малых датасетов и сложных метриках, но подчёркивается огромный потенциал трансформеров видео-текста в рентгенологии и хирургии[19].

- Из российских источников: Специфических публикаций по генерации медицинских изображений в РФ пока мало. Отмечается лишь, что ИИ может создавать виртуальных помощников и симуляции, но эти разработки на ранней стадии (см. обзор Кошечкина & Хохлова, 2024, раздел 5).

5. Этика, безопасность и регулирование ИИ в медицине

- Bouderhem (HSS Communications, 2024) – Исследование обобщает технические, этические и регуляторные вызовы ИИ в здравоохранении. Выделены ключевые темы: приватность, согласие пациентов, автономия, ответственность, справедливость, беспристрастность алгоритмов. Выявлены «правовые пустоты» и сложности обеспечения прозрачности и подотчетности. Предлагается более тесное международное сотрудничество (при активной роли ВОЗ) и гармонизация стандартов: в том числе использование европейского опыта (GDPR, AI Act) как модели при обновлении Международных санитарных регламентов[20].

- Haltaufderheide & Ranisch (npj Digital Medicine, 2024) – (См. раздел 2 выше) Этот обзор также служит этическим напоминанием: отмечается, что интеграция LLM в медицину связана с рисками и требует руководящих принципов. Главные опасения – предвзятость, непрозрачность, нарушение конфиденциальности, а наиболее остро – генерация правдоподобного ложного контента. Авторы призывают сконцентрироваться на разработке этических рамок для надзора за человеком на всех этапах использования ИИ[11].

- Русские публикации: Статья «Этические проблемы внедрения ИИ в здравоохранении» (журнал Медицинская этика, 2024) подчёркивает, что внедрение ИИ несёт не только выгоды, но и новые риски. Главный этический императив – безопасность пациентов: ИИ может улучшить результаты, но создаёт риски (алгоритмическая предвзятость, утечка данных, ошибки в решениях)[21]. Необходимость соблюдения приватности, прозрачности алгоритмов и ответственности врачей рассматривается как залог доверия к ИИ[22]. Отмечено также, что ИИ должен дополнять, а не заменять опыт врачей, и выдвинуты требования информированного согласия, аутентификации и аудита систем ИИ.

- Дополнительно: Минздрав России в 2024 г. анонсировал разработку «Кодекса этики ИИ в медицине» (актуально с декабря 2024), однако официальные публикации ещё ожидаются. Важно следить за появлением национальных стандартов ИИ (подкомитет ПК01/ТК164) и рекомендаций ВОЗ в области цифрового здоровья.

Источники: публикации за 2024–2025 годы, включая Nature, Science, Lancet (Digital Health/EBioMed), Nature Medicine, npj Digital Medicine, Lancet Regional Health, Scientific Reports и др. (см. ссылки [1][2][3][4][8][9][10][12][13][14][15][17][18][19][20][11][5][6][7][16][22][21]).

[1] Randomised controlled trials evaluating artificial intelligence in clinical practice: a scoping review - PubMed

https://pubmed.ncbi.nlm.nih.gov/38670745/

[2] Benefits and harms associated with the use of AI-related algorithmic decision-making systems by healthcare professionals: a systematic review - PubMed

https://pubmed.ncbi.nlm.nih.gov/39687669/

[3] AI-guided patient stratification improves outcomes and efficiency in the AMARANTH Alzheimer’s Disease clinical trial | Nature Communications

[4] Identification of patients at risk for pancreatic cancer in a 3-year timeframe based on machine learning algorithms | Scientific Reports

[5][6][16] Перспективы применения технологий искусственного интеллекта для цифровой трансформации здравоохранения | Российский журнал телемедицины и электронного здравоохранения

[7] AN OVERVIEW OF THE CURRENT SITUATION AND TENDENCIES | Cifra. Biomedical Sciences

https://medbio.cifra.science/en/archive/2-2-2024-september/10.60797/BMED.2024.2.4

[8] Towards conversational diagnostic artificial intelligence | Nature

[9] A generalist medical language model for disease diagnosis assistance | Nature Medicine

[10] The Diagnostic and Triage Accuracy of the GPT-3 Artificial Intelligence Model - PMC

https://pmc.ncbi.nlm.nih.gov/articles/PMC9915829/

[11] The ethics of ChatGPT in medicine and healthcare: a systematic review on Large Language Models (LLMs) | npj Digital Medicine

[12] Impact of human and artificial intelligence collaboration on workload reduction in medical image interpretation | npj Digital Medicine

[13] Effects of artificial intelligence implementation on efficiency in medical imaging—a systematic literature review and meta-analysis | npj Digital Medicine

[14] [2408.12491] AI in radiological imaging of soft-tissue and bone tumours: a systematic review evaluating against CLAIM and FUTURE-AI guidelines

https://arxiv.org/abs/2408.12491

[15] Foundation model for cancer imaging biomarkers | Nature Machine Intelligence

[17] Self-improving generative foundation model for synthetic medical image generation and clinical applications - PubMed

https://pubmed.ncbi.nlm.nih.gov/39663467/

[18] A review on generative AI models for synthetic medical text, time series, and longitudinal data | npj Digital Medicine

[19] Multimodal generative AI for interpreting 3D medical images and videos | npj Digital Medicine

[20] Shaping the future of AI in healthcare through ethics and governance | Humanities and Social Sciences Communications

[21][22] Медицинская этика

https://medet.rsmu.press/archive/2024/1/7/content?lang=ru

2025, Обзор ГНМБ

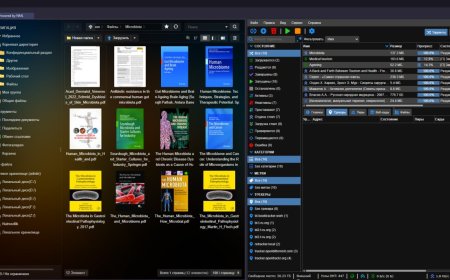

Файлы

Какова ваша реакция?